Около 0,07% еженедельных пользователей ChatGPT имеют признаки психических расстройств – психозов или суицидальных мыслей. Это, по оценкам OpenAI, сотни тысяч человек. Об этом [BBC], ссылаясь на исследования разработчика популярного чат-бота. В компании также отмечают, что в диалогах около 0,15% пользователей есть признаки потенциального планирования суицида или намерения к нему.

В OpenAI разработали специальные сценарии ответов для ChatGPT, которые призваны поощрять пользователей обращаться за помощью к реальным людям – психологам, родственникам или горячим линиям.

Также недавние обновления модели направлены на то, чтобы более эмпатично реагировать на возможные признаки бреда или мании, а также распознавать косвенные сигналы о риске самоповреждения.

Трагедия, изменившая подход к безопасности

Ранее в США родители 16-летнего парня подали иск против OpenAI после его самоубийства. Они заявили, что чат-бот якобы подтолкнул их сына к трагическому шагу, а также обвинили компанию в создании продукта, способствующего психологической зависимости пользователей.

OpenAI тогда заявила, что такие случаи оказывают глубокое влияние на работников компании, и пообещала внести изменения в протоколы безопасности.

В частности, были анонсированы функции родительского контроля и система уведомлений о возможных суицидальных мнениях. Если ребенок находится в состоянии острого стресса, родители могут получить соответствующее уведомление.

Искусственный интеллект и этика эмоционального взаимодействия

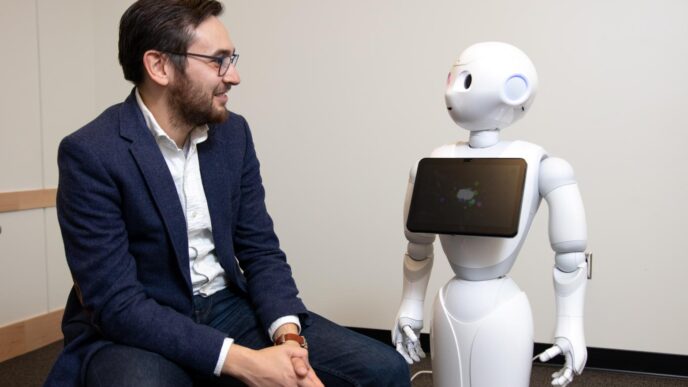

Развитие генеративных систем, таких как ChatGPT, поставило новый этический вопрос: должен ли искусственный интеллект нести моральную ответственность за эмоциональное влияние на пользователей.

Несмотря на то, что современные модели способны имитировать сочувствие, они не обладают подлинным пониманием или эмпатией. Это создает риск, когда человек воспринимает цифрового собеседника как того, кто его «слышит», хотя на самом деле это лишь результат алгоритмического анализа языка.

Психологи предостерегают, что переживающие кризис пользователи могут переносить свои эмоциональные ожидания на программу, вместо того чтобы обратиться за помощью к специалисту. Иллюзия понимания создает кратковременное облегчение, но не решает проблему.

Кроме того, привычка получать быстрый и дружеский ответ от ИИ может формировать психологическую зависимость. Со временем человек начинает испытывать большее доверие к алгоритму, чем к реальным людям.

Поэтому эксперты настаивают на необходимости создания этических границ в коммуникации между пользователем и искусственным интеллектом. Программные системы должны четко указывать, что они не являются заменой психотерапии и всегда рекомендуют обращаться к живому специалисту в случае кризисных состояний.

Психическое здоровье в цифровые сутки

Цифровые технологии влияют на наш мозг глубже, чем кажется. Постоянное взаимодействие с экранами изменяет ритм мышления, внимание и эмоциональную регуляцию.

Сегодня человек часто проводит больше времени, общаясь с системами типа ChatGPT, чем с друзьями или коллегами. Это постепенно формирует новый тип когнитивного опыта – «цифровое мышление», где главным источником информации становится алгоритм.

По мнению исследователей, такое взаимодействие может усиливать ощущение изоляции, даже если человек постоянно «на связи». Мозг реагирует на сообщения от ИИ так же, как на человеческую коммуникацию, но эмоциональной обратной связи при этом не получает. Поэтому пользователь может чувствовать себя истощенным, несмотря на ощущение «общения».

Ученые отмечают важность цифровой грамотности – особенно среди подростков и молодежи. Понимание границ технологий помогает пользователям осознавать, что искусственный интеллект является только инструментом, а не другом или советником.

Психическое здоровье в цифровые сутки требует навыка саморегуляции, умения отключаться и поддерживать реальные отношения вне онлайн-среды.

Взгляд в будущее

OpenAI признает, что искусственный интеллект уже сегодня влияет на психоэмоциональное состояние пользователей, поэтому внедряет протоколы безопасности, чтобы снизить риски.

Однако это только первый шаг. Будущее таких систем зависит от того, насколько они будут прозрачно сочетать технологические возможности с этическими стандартами.

ИИ может быть мощным инструментом поддержки, но только тогда, когда человек понимает его пределы.

В мире, где технологии все глубже проникают в наши эмоции, главная задача – сохранить человечность и умение обращаться друг к другу, а не только искусственному собеседнику.